Robots txt: Qué es y cómo usarlo para optimizar tu web

El archivo robots.txt es un documento clave que permite a los administradores de sitios web controlar cómo los motores de búsqueda interactúan con su contenido. Al incluir instrucciones específicas, se puede regular el acceso de los bots a diferentes secciones del sitio. Los consultores SEO solemos trabajar con el para optimizar la visibilidad y el rendimiento en los resultados de búsqueda. A través de estos sencillos pasos, se puede mejorar el posicionamiento y mantener la seguridad del contenido sensible.

Cómo funciona el archivo robots.txt

El archivo robots.txt desempeña un papel fundamental en la interacción entre los sitios web y los motores de búsqueda. A continuación, se analizan aspectos clave sobre su funcionamiento.

Ubicación y detección por los rastreadores

El archivo robots.txt debe estar situado en la raíz del dominio, lo que permite que los rastreadores lo encuentren de manera sencilla al acceder al sitio web. Por ejemplo, si se tiene un dominio como mi-sitio.com, el archivo se puede localizar en mi-sitio.com/robots.txt. Este comportamiento es estándar para todos los bots que cumplen con el Protocolo de Exclusión de Robots.

Interpretación de las instrucciones por los bots

Cuando un bot accede a un sitio, su primer paso es buscar y leer el archivo robots.txt. Este acto permite que el bot entienda qué áreas del sitio web están permitidas para rastrear y cuáles han sido restringidas. Las instrucciones se interpretan siguiendo la sintaxis específica del archivo, donde cada comando indica acciones claras para los motores de búsqueda. Si un bot encuentra una instrucción «Disallow» seguida de una ruta, se le indica que no acceda a esa dirección particular.

Diferencias entre robots.txt y metadatos de noindex

Aunque ambos mecanismos sirven para controlar la indexación de contenido, existen diferencias importantes entre ellos. El archivo robots.txt impide que los rastreadores accedan a ciertas áreas del sitio, mientras que los metadatos de noindex permiten que una página sea rastreada pero no indexada en los resultados de búsqueda. Esto significa que, si un archivo robots.txt bloquea una URL, esta no será rastreada ni indexada; en cambio, si se utiliza un metadato noindex en una página accesible, los motores de búsqueda la rastrearán pero no la mostrarán en sus resultados.

Sintaxis y estructura del archivo robots.txt

La sintaxis del archivo robots.txt es crucial para establecer qué partes de un sitio web deben ser accesibles o restringidas para los bots de los motores de búsqueda. A continuación, se describen los elementos clave que componen este archivo.

Comando User-agent

El comando User-agent se utiliza para especificar a qué bot se dirige una determinada regla. Se puede aplicar a todos los motores de búsqueda o a uno en particular, según las necesidades del administrador del sitio.

Especificación para todos los motores de búsqueda

Para aplicar una instrucción a todos los bots, se utiliza el asterisco (*) tras el comando User-agent. Por ejemplo:

User-agent: *

Esta línea indica que las reglas que siguen a continuación se aplican a todos los motores de búsqueda sin excepción.

Definición para user agents específicos

Si se desea bloquear o permitir el acceso a un bot específico, se debe introducir su nombre. Por ejemplo:

User-agent: Googlebot

En este caso, las instrucciones subsiguientes solo se aplicarán al bot de Google.

Comandos Disallow y Allow

Los comandos Disallow y Allow determinan qué se permite o se restringe en el rastreo de un sitio. A través de estos comandos, el administrador puede gestionar la disponibilidad de contenido.

Ejemplos de uso de Disallow

El comando Disallow se utiliza para restringir el acceso a ciertas páginas o directorios. Por ejemplo:

Disallow: /privado/

Con esta instrucción, los bots no podrán acceder a ninguna URL que comience con /privado/.

Ejemplos de uso de Allow

El comando Allow permite el acceso a una página o documento específico incluso cuando su directorio padre está restringido. Por ejemplo:

Disallow: /carpeta-restringida/ Allow: /carpeta-restringida/documento-permitido.html

Esto indica que, aunque se prohíbe el acceso a toda la carpeta, se permite el acceso a un archivo específico.

Mapa del sitio y su inclusión

Incluir un mapa del sitio dentro del archivo robots.txt ayuda a los motores de búsqueda a identificar rápidamente las URLs más importantes de un sitio.

Comando Sitemap

El comando Sitemap se utiliza para indicar la ubicación del mapa del sitio. Un ejemplo de este comando sería:

Sitemap: https://mi-sitio.com/sitemap.xml

Este comando facilita a los bots encontrar y rastrear las páginas significativas del sitio web.

Beneficios de incluir el mapa del sitio en robots.txt

Incorporar el mapa del sitio en el archivo robots.txt ofrece múltiples beneficios, como:

- Mejora la eficacia del rastreo por parte de los motores de búsqueda.

- Facilita la indexación de contenido actualizado y relevante.

- Optimiza el presupuesto de rastreo, dirigiendo los bots hacia las páginas más importantes del sitio.

Manual para crear un archivo robots.txt

Crear un archivo robots.txt adecuado es fundamental para gestionar el acceso de los motores de búsqueda a los elementos de un sitio web. Este manual describe los pasos necesarios para llevar a cabo esta tarea de manera eficaz.

Pasos iniciales y herramientas necesarias

Antes de comenzar, es útil contar con herramientas básicas y seguir un proceso estructurado. Los elementos que se requieren incluyen:

- Un editor de texto, como Notepad o cualquier otro programa que permita crear archivos de texto.

- Acceso al servidor donde se aloja el sitio web, ya sea a través de FTP o un panel de control.

- Conocimiento básico sobre las secciones que deben ser bloqueadas o permitidas para los bots.

Generación de reglas y especificaciones

El siguiente paso implica la creación de las reglas que se incluirán en el archivo. Para ello, es esencial seguir un formato específico y tener claro qué contenido se desea permitir o restringir. Las reglas básicas son:

- User-agent: Especifica a qué bot se aplican las reglas.

- Disallow: Indica qué páginas o directorios no deben ser rastreados.

- Allow: Permite el acceso a ciertas páginas dentro de un directorio bloqueado, si es necesario.

- Sitemap: Proporciona la ubicación del mapa del sitio para ayudar a los bots a encontrar contenido relevante.

Las decisiones sobre qué incluir en este archivo deben basarse en la estructura del sitio y la relevancia de cada contenido respecto a la estrategia de SEO.

Subida y verificación en el directorio raíz

Una vez creado el archivo, el siguiente paso es subirlo al servidor. La ubicación correcta para este archivo es la raíz del dominio. Por ejemplo, debe ser accesible en https://mi-sitio.com/robots.txt.

Después de la carga, es importante verificar que el archivo ha sido configurado correctamente. Esto se puede hacer utilizando herramientas como Google Search Console, que permite comprobar cómo los motores de búsqueda interpretan las reglas establecidas en el archivo robots.txt.

Mejores prácticas para utilizar robots.txt

El uso adecuado del archivo robots.txt es esencial para maximizar la efectividad en la gestión de acceso de los bots a un sitio. Implementar prácticas recomendadas garantiza un control óptimo sobre la indexación del contenido.

Verificaciones y actualizaciones regulares

El mantenimiento del archivo robots.txt debe ser una actividad continua. Revise periódicamente su contenido para asegurarse de que las instrucciones sigan siendo relevantes. Es común que la estructura del sitio web cambie con el tiempo, y es crucial actualizar las reglas según sea necesario.

- Realizar auditorías mensuales para identificar posibles errores.

- Eliminar pautas obsoletas que ya no se aplican al contenido actual.

- Agregar nuevas secciones que deban ser restringidas o permitidas.

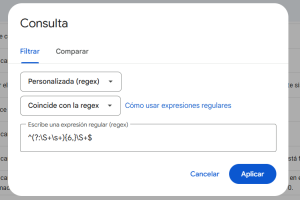

Uso eficaz de herramientas como Google Search Console

Las herramientas de webmasters, como Google Search Console, son fundamentales para comprobar el correcto funcionamiento del archivo robots.txt. Esta plataforma permite a los administradores verificar qué URLs son accesibles para los bots y cuáles están bloqueadas.

- Utilizar la herramienta de prueba de robots.txt para identificar errores de implementación.

- Monitorear las estadísticas de rastreo proporcionadas por la consola para evaluar la efectividad del archivo.

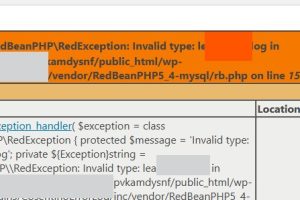

Consideraciones para sitios web en WordPress

Los sitios en WordPress deben tener especial cuidado con el archivo robots.txt, dado que la plataforma facilita la creación de contenido sin conocimientos técnicos avanzados. Es recomendable utilizar plugins que simplifiquen la gestión del archivo, garantizando así una correcta implementación.

- Seleccionar un plugin confiable que permita editar el robots.txt de forma sencilla.

- Configurar opciones predeterminadas, asegurándose de que las páginas no deseadas estén correctamente bloqueadas.

- Revisar la compatibilidad del plugin con otras herramientas de SEO instaladas en el sitio.

Ejemplos prácticos de archivos robots.txt

El archivo robots.txt es una herramienta esencial para regular el acceso de los motores de búsqueda a diferentes secciones de un sitio web. A continuación, se presentan ejemplos prácticos que ilustran su uso en diversas situaciones.

Ejemplo básico para pequeños sitios web

En un sitio web pequeño, donde el contenido es sencillo y no hay áreas críticas que necesiten ser restringidas, un archivo robots.txt básico puede ser efectivo. Un diseño típico podría ser el siguiente:

User-agent: * Disallow: /private/ Allow: /

En este caso, se permite el acceso general a todas las páginas, excepto a la carpeta private, donde se podría almacenar información sensible o administrativa.

Ejemplo avanzado con múltiples restricciones

Para sitios más complejos, que requieren un control más preciso, el archivo puede incluir múltiples directivas. Este es un ejemplo que podría utilizar un sitio corporativo:

User-agent: * Disallow: /admin/ Disallow: /temp/ Disallow: /private/ Allow: /blog/ Allow: /public/ Sitemap: https://mi-sitio.com/sitemap.xml

En este archivo, se restringe el acceso a las carpetas de admin, temp y private, mientras que se permite el rastreo de las secciones blog y public. También se incluye la ubicación del mapa del sitio, lo que facilita a los bots encontrar contenido relevante rápidamente.

Ejemplo de robots.txt en un sitio de e-commerce

Los sitios de comercio electrónico, debido a su gran cantidad de productos y contenido duplicado, pueden beneficiarse de una configuración específica. Un ejemplo sería:

User-agent: * Disallow: /checkout/ Disallow: /cart/ Disallow: /user/ Allow: /products/ Sitemap: https://mi-sitio.com/sitemap.xml

En este archivo, se prohíbe el acceso a las secciones checkout, cart y user para proteger información sensible del usuario. Se permite el rastreo de la sección de products, asegurando que los productos sean indexados y visibles en los resultados de búsqueda.

Limitaciones y consideraciones de seguridad

El archivo robots.txt es una herramienta valiosa para regular el acceso de los motores de búsqueda al contenido de un sitio web. Sin embargo, presenta ciertas limitaciones y consideraciones relacionadas con la seguridad que es necesario tener en cuenta.

Riesgos de exposición no intencionada de URLs

A pesar de su función protectora, el uso de robots.txt puede resultar en la exposición accidental de URLs que no deberían ser visibles para los motores de búsqueda. Esto puede suceder si se bloquean ciertas áreas del sitio, pero se dejan accesibles enlaces directos a otras páginas. Por ejemplo, si se permite el rastreo a una sección que contiene enlaces a contenido privado, estos enlaces pueden ser descubiertos por los usuarios o rastreadores externos, comprometiendo la intención de privacidad del contenido.

Limitaciones en la protección de datos

El archivo robots.txt no proporciona una verdadera protección de datos. Aunque indica a los bots los recursos que no deben ser rastreados, no impide que esos recursos sean accesibles a través de enlaces directos. Esto significa que, aunque un administrador desee ocultar ciertos archivos o páginas, estos aún podrían ser indexados si se accede a ellos a través de otras vías. La información permanece disponible si no se implementan otras medidas de seguridad, como contraseñas o configuraciones de acceso directo en el servidor.

Bots que ignoran el protocolo de exclusión de robots

No todos los bots respetan las instrucciones contenidas en el archivo robots.txt. Existen bots maliciosos diseñados para ignorar estas directrices y acceder a cualquier parte del sitio. Estos bots pueden ser utilizados para realizar scraping de contenido, recopilar datos de usuarios o incluso llevar a cabo ataques. Esto plantea un riesgo significativo para la seguridad del sitio, ya que podría facilitar el acceso a áreas que se esperaban restringidas.

Comprendiendo el archivo robots.txt

El archivo robots.txt es un elemento fundamental en la gestión de acceso de los motores de búsqueda a un sitio web. Este apartado se centra en su definición y contexto histórico, proporcionando una base para entender su función y relevancia en el entorno digital actual.

Definición y propósito del archivo robots.txt

El archivo robots.txt es un archivo de texto que se coloca en la raíz de un sitio web. Su principal función es indicar a los motores de búsqueda cuáles partes del contenido deben ser rastreadas y cuáles deben ser excluidas. Esta gestión permite a los administradores de sitios web controlar la indexación de su contenido de manera efectiva.

Utilizar correctamente el archivo robots.txt puede contribuir a optimizar el presupuesto de rastreo, evitando que los bots pierdan tiempo en secciones irrelevantes del sitio. Esto se traduce en una mejora en la visibilidad en los resultados de búsqueda, así como en una experiencia de usuario más dirigida.

Historia y evolución del protocolo de exclusión de robots

El Protocolo de Exclusión de Robots (REP), que incluye el uso de robots.txt, fue establecido a finales de la década de 1990. Originalmente, surgió como una respuesta a la necesidad de los administradores web de controlar el acceso a su contenido. Antes de su implementación, no existía una forma estandarizada de gestionar el rastreo por parte de los bots, lo que generaba problemas de indexación y tráfico indeseado.

Con el tiempo, el uso del archivo robots.txt se ha expandido y evolucionado. A medida que internet ha crecido, se han desarrollado mejores prácticas y herramientas para optimizar su uso. Hoy en día, muchos motores de búsqueda reconocen y respetan el archivo robots.txt, convirtiéndolo en una herramienta crucial en la estrategia de SEO de cualquier sitio web.

Aspectos clave sobre su evolución:

- En sus inicios, el enfoque del robots.txt era muy básico y se limitaba a instrucciones generales.

- Con el auge de los sitios dinámicos, se comenzaron a implementar prácticas más sofisticadas en su gestión.

- El protocolo ha sido adoptado por prácticamente todos los motores de búsqueda reconocidos, garantizando su relevancia en la actualidad.

Importancia del robots.txt en el SEO

El archivo robots.txt juega un papel fundamental en la optimización SEO al permitir el control sobre qué partes de un sitio web deben ser rastreadas e indexadas por los motores de búsqueda. A continuación, se desglosan los aspectos más relevantes de su importancia en este ámbito.

Optimización del presupuesto de rastreo

El presupuesto de rastreo se refiere al número de páginas que los motores de búsqueda están dispuestos a explorar dentro de un sitio web en un periodo de tiempo determinado. Un uso adecuado del archivo robots.txt puede ayudar a gestionar este presupuesto, redirigiendo los esfuerzos de los rastreadores hacia las páginas más relevantes y de mayor valor SEO.

- Bloquear páginas innecesarias o de poca relevancia, como formularios o áreas de usuario cerradas.

- Permitir el acceso a las páginas clave que contribuyen a mejorar la visibilidad en los motores de búsqueda.

Control del contenido duplicado

El contenido duplicado puede perjudicar las estrategias SEO al dividir el valor de los enlaces y potencialmente afectar al posicionamiento. Utilizar el archivo robots.txt para restringir el acceso a páginas duplicadas es una práctica eficaz.

- Evitar la indexación de páginas con contenido que no aporta valor, como las de resultados de búsqueda internos.

- Proteger las versiones duplicadas de productos en un sitio de comercio electrónico, por ejemplo.

Protección de contenido sensible

En muchos casos, es necesario mantener ciertos recursos o secciones del sitio inaccesibles para los motores de búsqueda. Esto no solo asegura la privacidad, sino que también contribuye a una experiencia de usuario más enfocada.

- Bloquear el acceso a archivos sensibles, como documentos internos o imágenes confidenciales.

- Controlar el acceso a secciones administrativas del sitio que no deberían ser indexadas.

Preguntas frecuentes sobre robots.txt

Esta sección aborda las dudas más comunes sobre el archivo robots.txt, aclarando su funcionamiento y cómo puede influir en la gestión de un sitio web.

Apasionado de la montaña, del SEO y la programación a partes iguales, llevo más de 20 años trabajando en distintos sectores, pero siempre enfocado a la web, si quieres saber más de mí, sigue el enlace.